In den letzten zwei Wochen, also etwa seit Anfang Februar, hat sich in den Google-SERPs einiges an Verschiebungen ergeben. Wer Kennzahlen wie den Sistrix-Sichtbarkeitsindex im Auge hat, stellt teilweise gravierende Veränderungen fest – positive für die einen, negative für andere. Und das quer durch alle Themenbereiche.

Beobachtungen zum Google-Update im Februar 2017

Schaut man ein wenig über den eigenen Tellerrand, und verschafft sich einen größeren Überblick, drängt sich der Verdacht auf, dass es sich um ein Qualitäts- und »Authority«-Update handelt. Wahrscheinlich wirkt sich hierbei die KI von RankBrain mit aus.

Relativ klare Tendenzen erkennbar

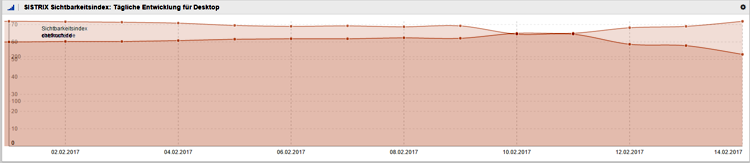

Betrachtet man beispielsweise die direkten Wettbewerber chefkoch.de und eatsmarter.de stellt man bei chefkoch.de einen Anstieg von 11% in der Sistrix-Sichtbarkeit fest, während eatsmarter um 15% an Sichtbarkeit verloren hat. Legt man nun die Sichtbarkeitsverläufe der letzten 14 Tage übereinander, ergibt sich ein interessantes Bild:

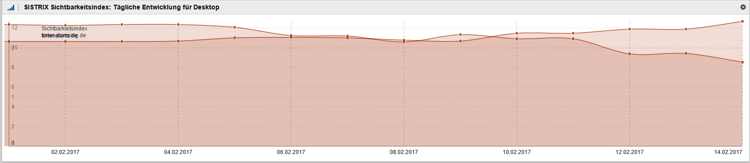

Das könnte nun natürlich ein purer Zufall sein. Deswegen gleich ein weiterer Vergleich. Ebenfalls direkte Wettbewerber: tintenalarm.de und toner-dumping.de

Schlussfolgerungen – gute Zeiten für Vorreiter

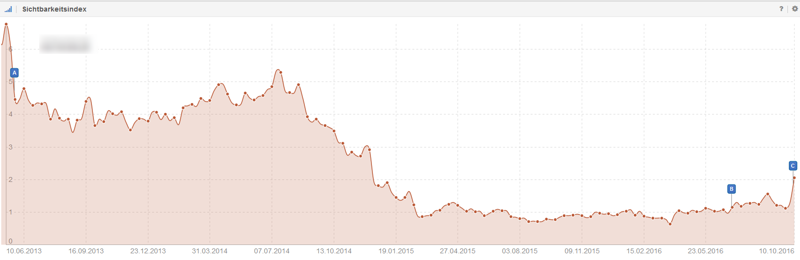

Man könnte hier jetzt auch noch eine Reihe weiterer Beispiele aufführen, aber ich will es bei diesen beiden belassen, die schon recht gute Rückschlüsse auf die Intention des Updates haben. Wer sich ein wenig im Netz auskennt, der weiß natürlich, dass chefkoch.de das »Original« ist. Absolut betrachtet kommt eatsmarter.de nicht im entferntesten an die Sichtbarkeit von Chefkoch heran. Allerdings konnte man in den letzten Monaten einen deutlichen Anstieg der Sichtbarkeit feststellen.

Dabei ergibt es sich, dass eatsmarter Inhalte ins Netz stellt, die jenen von Chefkoch ähneln. Dabei geht es weniger darum etwas zu kopieren. Aber wenn man etwa die Nährwerte und Zubereitung einer Süßkartoffel erklärt, dann ergeben sich recht ähnliche Inhalte.

Betrachtet man nun die Auswirkungen des letzten Updates bei einer Reihe von Beispielen, stellt man fest, dass Google den Platzhirschen zugeneigter zu sein scheint. Kommt hier womöglich die KI von RankBrain zum Zuge, die einer Seite die die jeweilige Inhalten schon deutlich länger im Netz eine höhere »Authority« zuweist? Das wäre ja nur menschlich – und das ist ja das Ziel von RankBrain.

Der Champions-Bonus

In vielen Sportarten in denen eine zumindest teilweise subjektive Bewertung über Sieg und Niederlage entscheidet, hat der amtierende Champ einen Bonus. So wird ein Boxer der nur genau so gut ist, wie der Weltmeister diesen schwer nach Punkten schlagen. Denn im Zweifel entscheiden sich die Kampfrichter für den amtierenden Champ – der seinen Bonus ja in gewisser Weise auch verdient.

Ähnlich scheint Google nun auch zu ticken. Denn alles in allem ist die klare Tendenz erkennbar, dass das Februar-Update die Seiten aufwertet, die auf ihrem Gebiet als erste hochwertige Inhalt ins Netz gestellt haben, und jene abstraft, die deren Beispiel nur folgen.

Dabei werden nach meinem Eindruck sogar OnPage-Faktoren deutlich vernachlässigt.

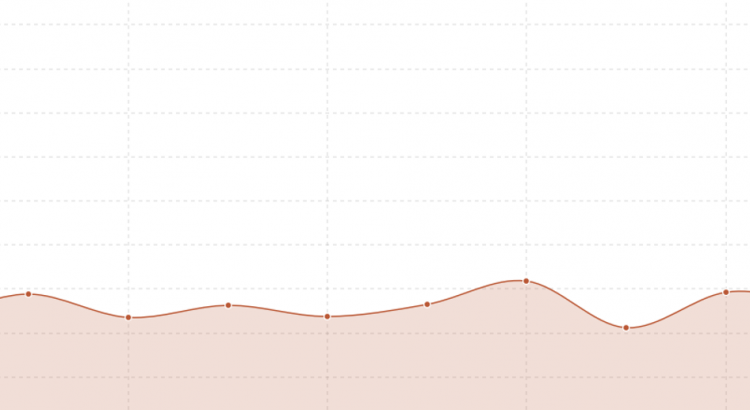

Vorreiter auf dem Smartphone – und dort weniger Verlust

Gestützt wird diese These auch durch Beobachtungen hinsichtlich der Sichtbarkeit auf dem Smartphone. Wir von Tonerdumping haben 2016 vor unseren Wettbewerbern auf ein responsives Design umgestellt. Hier waren wir also der Vorreiter. Interessanterweise ist hier kein Einbruch bei der Sichtbarkeit zu beobachten. Auch hier kann man natürlich einen Zufall annehmen. Dafür sind die Indizien aber doch ein bisschen zu eindeutig.

Fazit: abwarten, originäre Inhalte schaffen

Ziel von Google ist es Inhalte aus Nutzersicht zu bewerten. Da läge es nur nahe, jene Inhalte zu bevorzugen die zuerst da waren – so lange neuere Inhalte nicht deutlich umfangreicher oder hochwertiger sind. Das tun wir Menschen ja auch so – ob wir wollen oder nicht.

Im Grunde ist das auch alles nichts neues: »content is king«, und Content sollte originär sein, und nicht nur eine Nachahmung bereits vorhandener Inhalte. Denn, was hat der Nutzer denn davon? Natürlich nutzt man Vorbilder, aber man sollte diese nicht einfach nur kopieren.

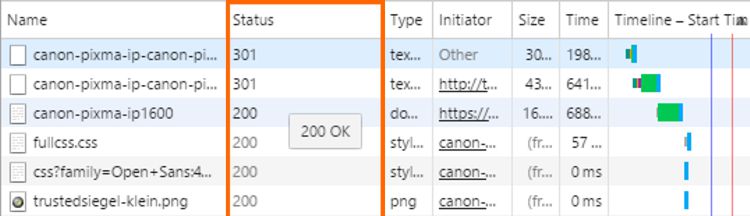

Ok, so groß waren die Wirkungen, bzw. Folgen nun erstmal nicht, da der Fehler noch innerhalb eines großen Umbruchs auffiel und behoben werden konnte. Wäre dem nicht so, würden die Folgen garantiert größer ausfallen. Worum geht es?

Ok, so groß waren die Wirkungen, bzw. Folgen nun erstmal nicht, da der Fehler noch innerhalb eines großen Umbruchs auffiel und behoben werden konnte. Wäre dem nicht so, würden die Folgen garantiert größer ausfallen. Worum geht es?